Warum „KI“ mir derzeit keine Arbeit erspart.

In meinem vorangegangenen Post habe ich geschrieben, dass ich derzeit keinen Gewinn darin sehe, „KI“-Werkzeuge in der Schule verstärkt einzusetzen. Hier möchte ich nun ein Beispiel für Schwierigkeiten geben, die ich damit habe. Denn in der Diskussion reden wir in meiner Wahrnehmung inzwischen öfter von Potenzialen oder Gefahren und seltener über Konkretes.

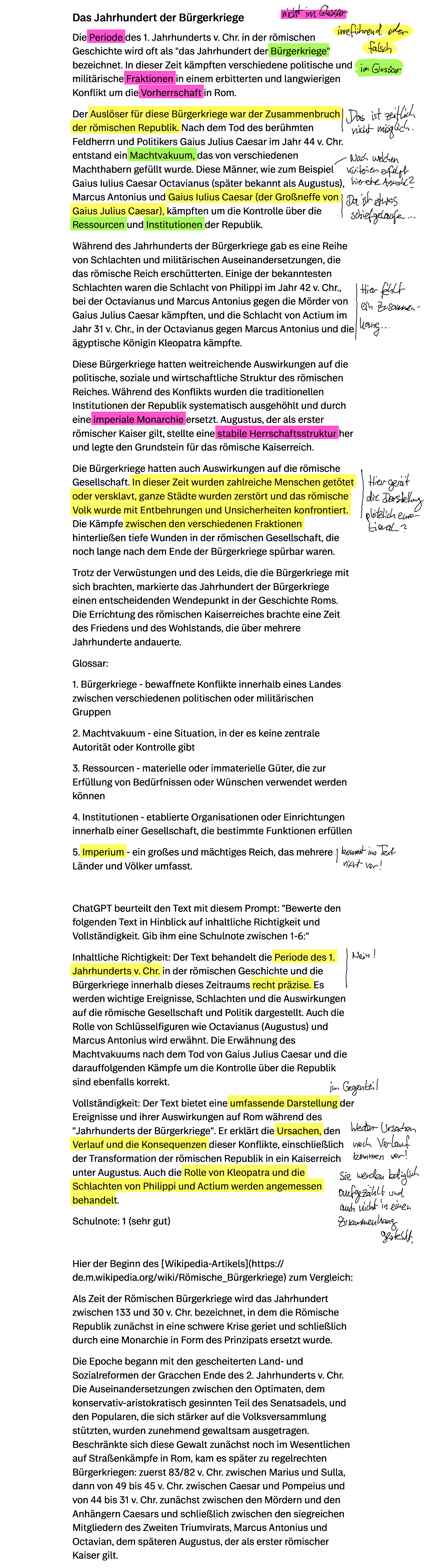

Ich habe die Seite eines „KI“-Startups genutzt, um mir einen Informationstext über das sog. „Jahrhundert der Bürgerkriege“ der römischen Geschichte (den Zeitraum von etwa 133-31 v. Chr.) zu erstellen. Das Startup gibt leider keine Auskunft darüber, mit welcher Technologie im Hintergrund gearbeitet wird (meistens ist es ja die Schnittstelle von OpenAI, die genutzt wird.)

Der ausgegebene Text ist jedenfalls gefährlich unvollständig. Gefährlich deshalb, weil er in weiten Teilen lesbar ist und für einen Laien zum überwiegenden Teil plausibel erklingen dürfte. Das Ergebnis belegt einmal mehr, was schon seit dem Aufkommen der Diskussion klar ist: Als Wissensmaschine taugen große Sprachmodelle nicht – im Gegenteil.

Da die Befürworter des Einsatzes von solchen Tools und ihre Unternehmen aber auch die Fähigkeiten von „KI“ im Umgang mit bestehenden Texten so betonen, habe ich ChatGPT im Anschluss dazu aufgefordert, den Text zu bewerten (Prompt etc. sie unten). Auch die Bewertung des Textes ist in vielerlei Hinsicht unzureichend und irreführend.

Als Vergleichstext habe ich den allgemeinen Absatz des Wikipedia-Artikels gegenübergestellt, der das Thema bereits um Längen besser darstellt.

Das alles zusammengenommen bestärkt mich eher in meiner Position zu diesen Werkzeugen: Es kommt bisher nichts Gutes dabei heraus und erspart mir auch keine Arbeit in der Vorbereitung oder Einschätzung von Texten.

Schreibe einen Kommentar